Executive Summary

Wi-Fi-Surveys müssen nicht sperrig und kompliziert sein. Clip ist ein leichtes, kabelloses Messgerät, das zusammen mit einer Smartphone-App zu einem agilen Survey-Werkzeug wird. Mit nur zwei Radio-Modulen statt vier – und damit deutlich günstiger im Vergleich zu bisher verfügbaren professionelle Alternativen. Was zunächst wie ein Nachteil klingt, stellt sich in der Praxis als nahezu irrelevant heraus. Hier sei der Oscium Nomad, der SIDOS Wave oder die Sidekick Serie von Ekahau erwähnt die in einem anderen Preissegment und somit auch einem anderen Leistungsumfang liegen. – Clip richtet sich an Techniker, IT-Admins und Netzwerk-Profis, die schnell, unauffällig und zuverlässig arbeiten müssen. Die echte Praxis der letzen Tage mit dem CLIP zeigt ganz klar, der Hauptvorteil liegt in der Größe und Unsichtbarkeit bei der Messung. Das beschleunigt und vereinfacht den Ablauf der echten Messung vor Ort massiv.

Clip funktioniert kabellos & nahtlos mit Hamina Wireless (Planner & Onsite) und ermöglicht:

– AP-on-a-Stick-Surveys (Planung validieren vor Installation)

– Post-Installation-Validierung (passt die Coverage wirklich?)

– Live-Troubleshooting (schnell reagieren auf Beschwerden)

– Systematische Lag-Fallen-Identifikation

(Co-Channel Interference, Roaming-Lücken, TX-Power-Fehler, Jitter)

Im Gegensatz zu vollautomatisierten Remote-Lösungen wie SIDOS Deep Survey bleibt der Survey-Prozess mit Clip etwas aufwendiger und erfordert zwei Geräte – bietet dafür aber maximale Kontrolle im Feld bei kostengünstiger Flexibilität.

Das Problem: Sperrige Survey-Geräte vs. praktischer Feldalltag

Klassische Wi-Fi-Site-Surveys verlangen nach Kompromissen:

Szenario 1: Großes Survey-Equipment

– iPad/Laptop, externe Messkarte/Sidekick, Kabel, Stromversorgung

– Auffällig, sperrig, unpraktisch im Gebäude

– Setup dauert 10+ Minuten, bis die erste Messung läuft

– Kosten: 3.000 € – 8.000 € für die Hardware allein

Szenario 2: Remote-Assessments (z.B. SIDOS Deep Survey)

– Kosten sparen (unter 200 € pro Survey)

– Aber: Keine Kontrolle vor Ort, keine Live-Adjustments

– Ideal für Überblick – Assessments, nicht für detailliertes Troubleshooting

Szenario 3: Smartphone-App allein

– Praktisch im Feld

– Aber: Zu schwach für professionelle Messungen

– Keine zuverlässige Erfassung aller APs, Frequenzbänder und Metriken

Clip adressiert exakt diese Lücke.

Es kombiniert die Flexibilität und Leichtigkeit eines Smartphone-Setups mit der Messgenauigkeit von professionellen Geräten – zu einem Bruchteil der Kosten.

Was ist Hamina CLIP?

Kernkonzept: Das intelligente Mess-Duo

Clip besteht aus zwei Komponenten, die zusammen ein professionelles Survey-System bilden:

1. Clip-Gerät (Hardware)

– Ein kleines, leichtes, tragbares Wi-Fi Messgerät mit 2 Radio-Modulen

(statt 4 wie beim Nomad von Oscium)

- Leicht, unauffällig, kabellos

- leicht mit Gürtelclip überall zu befestigen

- Direkt am iPhone/iPad/MacBook via BLE oder USB-C angebunden

- Misst Wi-Fi-Signale, Interferenzen, SNR auf allen Bändern (2.4, 5, 6 GHz)

- Unterstützt Wi-Fi 6, Wi-Fi 7 und ist Wi-Fi-8-ready

- Unterstützt PacketCapture

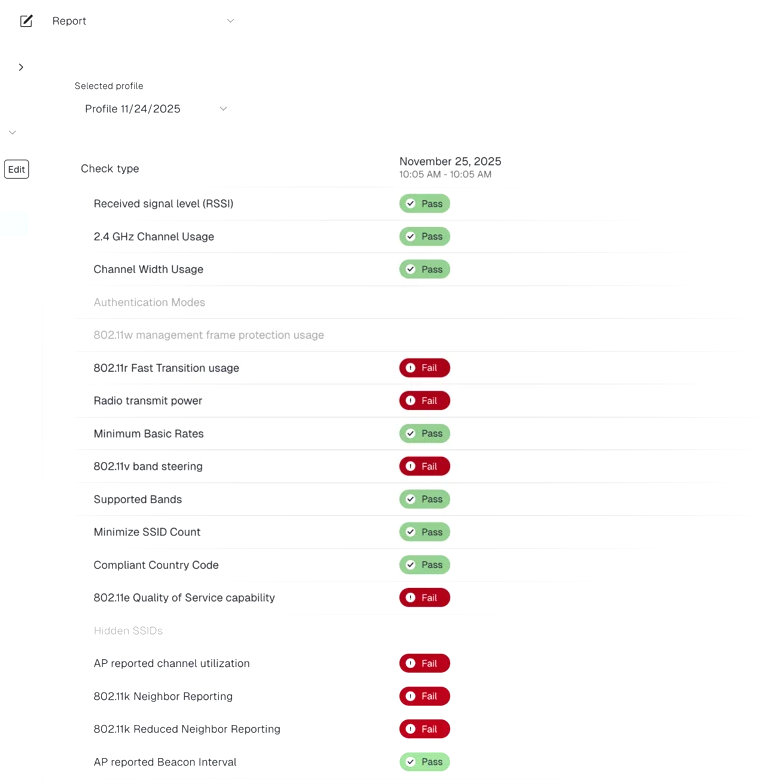

2. Hamina Onsite App as of today (Smartphone/iPad/MacBook)

– iOS-App für iPhone/iPad/MacBook

– Verbindet sich mit Clip über BLE oder USB-C

– Zeigt live Heatmaps, Coverage-Bilder, Interferenzmaps

– Integriert sich direkt mit Hamina Network Planner Cloud-Projekten

– Funktioniert wirklich kabellos – Daten synchronisieren über BLE zum Smartphone und in die Cloud

Das Prinzip: Clip ist der Messkopf, dein Smartphone ist die Intelligenz.

Zusammen ein Team.

Hier ist in Kürze deutlich mehr zu erwarten, einiges davon wurde beim Launch Event hier im Video bereits gezeigt.

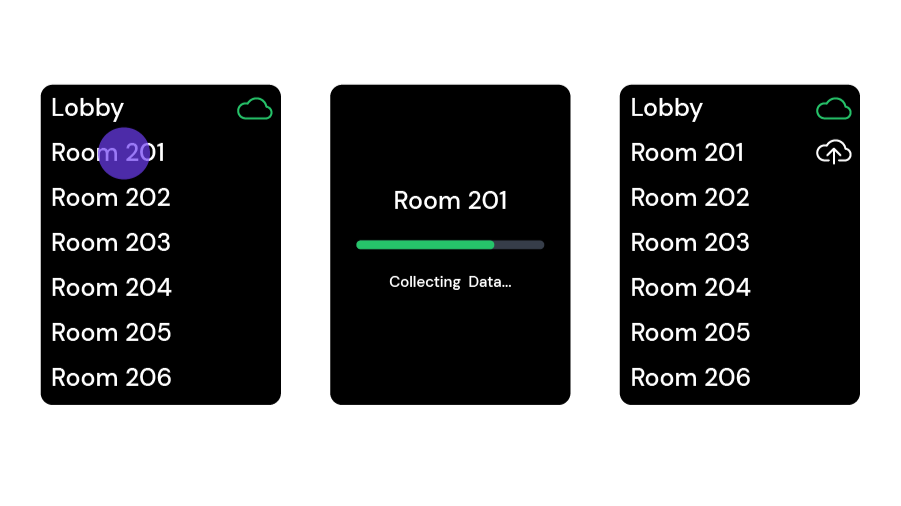

Wie Clip im Feld funktioniert

Schritt-für-Schritt im Alltag

Setup (5 Minuten)

1. Hamina Onsite App öffnen

2. Existierendes Hamina-Projekt laden (aus der Cloud oder offline-Kopie)

3. Clip via USB-C mit iPhone/iPad verbinden nur beim ersten Mal notwendig

4. BLE Pairing wird eingerichtet

5. USB-C Kabel wieder abziehen

6. App bestätigt die Verbindung → „Survey ready“

Kein Laptop. Kein Kabelwirrwarr. Kein Login-Chaos.

Survey durchführen (15–60 Minuten je nach Größe)

Drei Messmodi (wie beim Oscium Nomad):

Punkt-Messung (Point Survey)

– An kritischen Orten stehen bleiben (Besprechungsraum, Cafeteria, Dead Zone)

– App-Button tippen → Messung startet für 5–10 Sekunden

– Alle APs, SNR, Interferenzen werden erfasst

– Punkt wird auf dem Gebäudeplan markiert

– Live-Heatmap zeigt, wie sich die Coverage zusammensetzt

Linien-Messung (Line Survey)

– Gehweg abgehen, iPhone in der Hand

– App zeichnet kontinuierlich auf

– Alle 1–2 Meter ein Datenpunkt

– Ideal für Flure, Treppen, Lagerhallen mit langen Regalen

Wie funktioniert eine Linien-Messung?

Wenn du auf der Karte tippst und in gerader Linie zu gehen beginnst, scannt das Messgerät (Clip/Nomad) alle aktiven Kanäle ab und streamt die Daten in Echtzeit an die Hamina Onsite App. Die App speichert die Messpunkte in einem temporären Puffer.

Sobald du am Ende der Linie erneut auf der Karte tippst, verteilt Hamina Onsite die gesammelten Messpunkte gleichmäßig entlang der Linie. Daher ist ein gleichmäßiges Geh-Tempo so wichtig!

Kontinuierliche Messung (Continuous Survey)

– Clip läuft ständig mit, App im Hintergrund

– Perfekt für „walk-through Troubleshooting“

– Jede Position wird live mit Daten verknüpft

Eine kontinuierliche Messung ist im Prinzip eine Kette von Linienmessungen. Der Vorteil: Du kannst sehr schnell messen und erzeugst eine sehr datenreiche Aufzeichnung! Der Nachteil: Es braucht Übung, Koordination und schnelles Orientieren, um sie gut durchzuführen.

So führst du eine kontinuierliche Messung durch:

Startpunkt finden: Suche auf der Karte einen Ort, an dem du mit der Messung beginnen möchtest. Hinweis: Wie bei der Punktmessung musst du möglicherweise Orientierungspunkte (Fenster, Türen, Raumzentren) nutzen, um deine genaue Position zu bestimmen.

Auf der Karte tippen und sofort in gerader Linie mit gleichmäßigem Tempo losgehen. Bei jedem Stopp, Start oder Richtungswechsel erneut auf der Karte tippen. Zwischen den Tipps immer gleichmäßig gehen. Falls Fehler passieren (z. B. falscher Tipp), „Undo“-Button drücken, um den letzten Tipp rückgängig zu machen.

„Stop“-Button drücken, wenn du fertig bist.

Tipp für volle Räume: Ein Helfer, der vorangeht, Wege freimacht, Fragen von Passanten beantwortet und Türen öffnet, macht das Leben deutlich leichter.

Wie funktioniert eine kontinuierliche Messung technisch?

Wenn du auf der Karte tippst und in gerader Linie zu gehen beginnst, scannt das Messgerät (Clip/Nomad) alle aktiven Kanäle ab und streamt die Daten an die Hamina Onsite App, die sie in einem temporären Puffer speichert. Wenn du stoppst, startest oder die Richtung änderst und erneut auf der Karte tippst, verteilt Hamina Onsite die Messpunkte gleichmäßig entlang des letzten Streckenabschnitts. Deshalb ist gleichmäßiges Geh-Tempo so entscheidend!

„Ok, das verstehe ich jetzt. Ich gehe irgendwohin, stoppe, tippe auf die Karte, und gehe dann weiter?“

Nein! Tipp, wenn du startest, stoppst oder die Richtung änderst. Das heißt: Bei Richtungswechsel durchgehend weitergehen und auf der Karte tippen, wenn du die Richtung änderst. Wenn du es richtig machst, wirkt dein Gang etwas roboterhaft – was ja nützlich sein könnte für die Roboterkriege der 90er. 🤖

„Verstanden. Aber ich muss immer gleichmäßig gehen, oder?“

Zwischen den Tipps, ja. Bei jedem Tipp kannst du das Tempo ändern. Der Schlüssel: Gleichmäßigkeit zwischen den Tipps. Tipp auf der Karte und geh langsamer, um Zeit zum Planen deines nächsten Abschnitts zu gewinnen. 🧠

Hindernisse umgehen (Navigating Obstacles)

Wenn du an einem Hindernis (z. B. Tür) pausieren musst, so geht’s:

Zur Tür gehen und kurz vor dem Stehenbleiben auf der Karte tippen.

Während du stehst (Schlüssel rausholen, Tür öffnen etc.), sammelt Hamina weiter Messpunkte. Tür offen, bereit zum Durchgehen? Auf denselben Punkt auf der Karte tippen und weitergehen.

Warum das genial ist: Während du vor der Tür stehst, sammelt Hamina viele Messpunkte, die dann gemittelt werden. Die Messung an dieser Stelle (oder wo du mit jemandem geredet hast) wird extrem präzise! Funktioniert für jedes Hindernis – auch wenn du nur kurz pausieren oder dich neu orientieren willst.

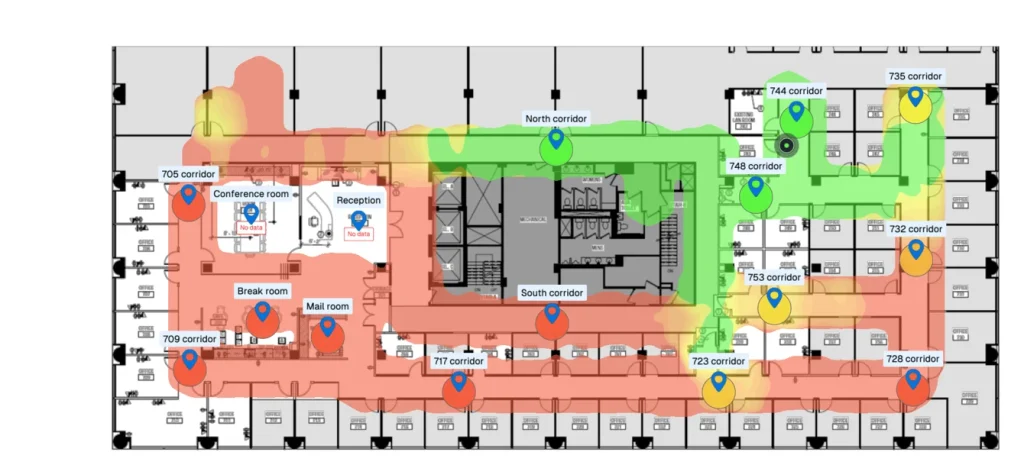

Live-Heatmaps im Feld

Während du surveyst, sieht dein Smartphone schon die Ergebnisse:

– Coverage-Heatmap: Wo ist das Signal gut, wo schwach?

– Interferenzmaps: Zu viel Overlap? Nachbar-APs im Weg?

– SNR-Karte: Signal-to-Noise-Ratio pro Zone

– AP-Detektion: Alle erkannten APs mit Kanal, Leistung, Clients

→ Du erkennst Probleme sofort und kannst korrigieren, nicht erst nach Tagen bei der Auswertung.

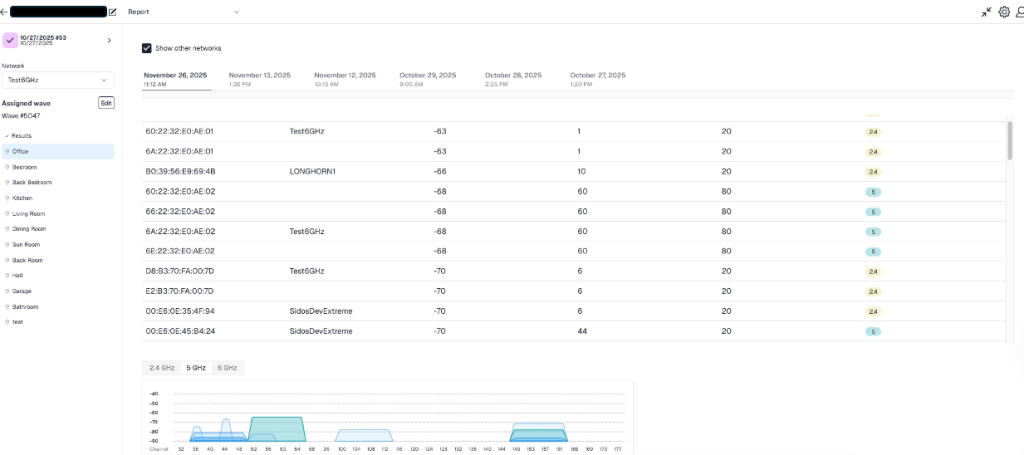

Dokumentation im Feld im Hamina CLIP

Die Onsite App erlaubt:

- Notizen/Kommentare direkt auf der Karte („Hier ist ein Metalldach – Signal bricht ein“)

- Fotos von kritischen Stellen (falsch positionierte AP, Dead Zone), direkt mit Verortung im Gebäudeplan und Synchronisation in die Cloud

- Markierung von Problemen

Das erspart dir später das Rätselraten: „Warum war diese Stelle nochmal schlecht?“

Synchronisation in die Cloud

Zurück im Büro:

1. Die Messdaten sind direkt in Hamina Survey verfügbar

2. Tiefere Analyse in der Web-UI verfügbar

3. Vergleiche mit vorherigen Surveys, Trend-Analysen

4. Teilen oder Export für Berichte, PDF, Dokumentation von Änderungen

Clip im Hamina Wireless Ökosystem

Drei Phasen des Netzwerk-Lebens

Phase 1: AP-on-a-Stick Surveys (Design-Validierung)

Problem: Du hast in Hamina Planner ein Netzwerk geplant. Aber passt es wirklich?

Lösung mit Clip:

– AP physisch auf einen Stativ montieren (z.B. mit einem Wi-FI Stand auf dem Kit: https://wlan-manufaktur.com/products/apos-site-survey-set)

– Mit Clip und Smartphone herumgehen

– Echtzeit-Heatmap zeigt tatsächliche Coverage

– Vergleich mit der Planung: „Passt es oder müssen wir den AP verschieben?“

– Vor der endgültigen Montage schon sicher sein

Zeitersparnis: Statt „erst bauen, dann ärgern“ – jetzt „vorher validieren“. Ersparte Kosten durch einen falsch platzierten AP: 500 – 2.000 €.

Phase 2: Post-Installation Validierung

Problem: APs sind verbaut. Entspricht das Netzwerk den Anforderungen?

Lösung mit Clip:

– Alle Aps/Radios einschalten, Clip-Survey starten

– Live-Heatmap zeigt: Gibt es Dead Zones? Zu viel Overlap? Schlechte Roaming-Pfade?

– Sofort korrigieren (Power, Kanal, Antennen – Ausrichtung) und neu validieren

– präzise Dokumentation für Kunden/Audits generieren

Zeit bis Handover: 2 Stunden statt 2 Tage (weil keine Post-Processing-Verzögerung dur lange PDF-Reports).

Phase 3: Live Troubleshooting & Monitoring

Problem: User beschwert sich: „Wi-Fi ist hier immer schlecht.“

Lösung mit Clip:

1. Schnell mit Clip & Smartphone zur fraglichen Stelle gehen

2. Onsite App starten → Live-Daten analysieren

3. Interferenzen? Co-Channel APs? Zu schwaches Signal?

4. Ursache in Minuten identifiziert statt zu raten

5. Korrektur vor Ort durchführen und Bereich validieren

Beispiel: „Der Konferenzraum hatte zu viel Interference von APs im U-NII-1 Band. Channel-Wechsel auf DFS-Kanal, neu gemessen, Problem gelöst.“

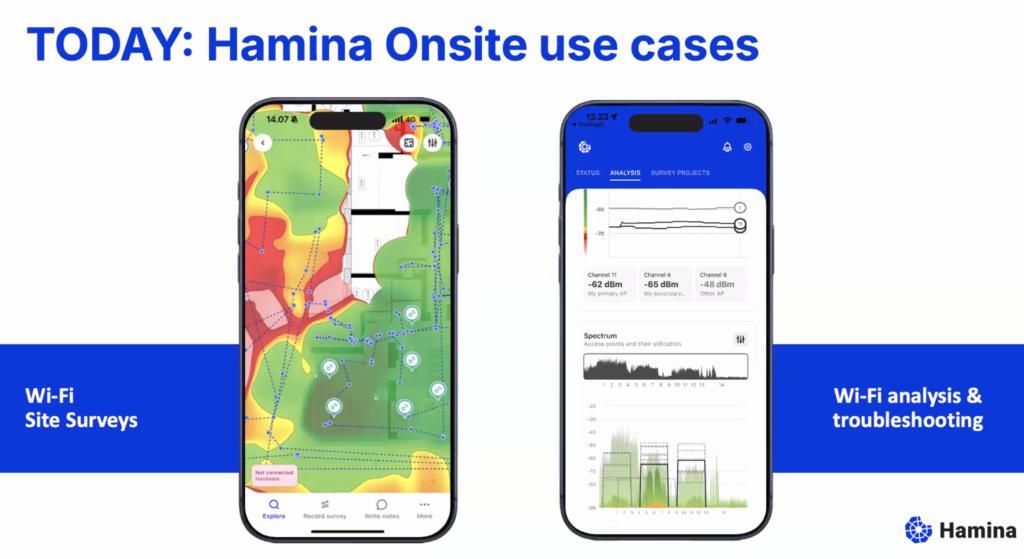

Clip vs. Oscium Nomad: Die Hardware-Perspektive

Hier ist die ehrliche Vergleichstabelle:

| Clip | Oscium Nomad | Gewinner | |

| Preis | 990 € inkl. 6 Mon. Cloud | $ 1710 ohne Cloud Lizenz | Clip ✓ |

| Radio-Module | 2 | 4 | Nomad ✓ |

| Antennen | 4 | 8 | Nomad ✓ |

| Größe/Gewicht | sehr klein (iPhone Größe) 282g | Kompakt, 2 x Clip, 415 g | Clip ✓ |

| Akkulaufzeit | 6 h | 4 h | Clip ✓ |

| Laden und Messen | JA | JA | unentschieden |

| Wi-Fi 7 / 8 Ready | JA | JA | unentschieden |

| Spektrumanalyse | Basis (Wi-Fi-Chip basiert) | Optional (ext. Gerät) | Nomad ✓ |

| Zielgruppe | Tägliche Surveys, AP-Stick, Troubleshooting | Enterprise-Deployments, komplexe RF | Clip für 80% der Use cases ✓ |

Interpretation

Clip gewinnt bei:

– Kosten (wichtig für SMB, Integratoren, Freelancer)

– Unauffälligkeit im Feld (keine „Warum-hältst-du-da-ein-Ding-hin? Was ist das an dem Gurt und warum hat es ein Kabel zu. iPhone/iPad?“ – Blicke)

– Akkulaufzeit nahezu endlos

(längere Surveys ohne Pause, kabellose Messung & USB-C laden gleichzeitig)

– Alltags-Bedienbarkeit (Smartphone-App ohne Kabel fühlt sich deutlich natürlicher an)

Nomad gewinnt bei:

– Parallel-Scanning

(4 Radios können verschiedene Kanäle gleichzeitig monitoren)

– volle Spektrumanalyse

(wichtig wenn nicht-Wi-Fi-Interferenzen ein Problem sein könnten)

– Enterprise-Anforderungen

(sehr großflächige Surveys, extreme Umgebungen – übersetzt was ist schon schlimmer als Züge, Bahnhöfe, Flughäfen oder Lagerhallen? Ja das geht wunderbar mit dem CLIP – Wer es nicht glaubt, meldet sich einfach.)

Faustregel: Wenn du 2+ Surveys pro Monat machst und Kosten wichtig sind → Clip.

Wenn du hochkomplex RF-Umgebungen analysierst und Spektrum-Details brauchst → Nomad + Spectrum Adapter

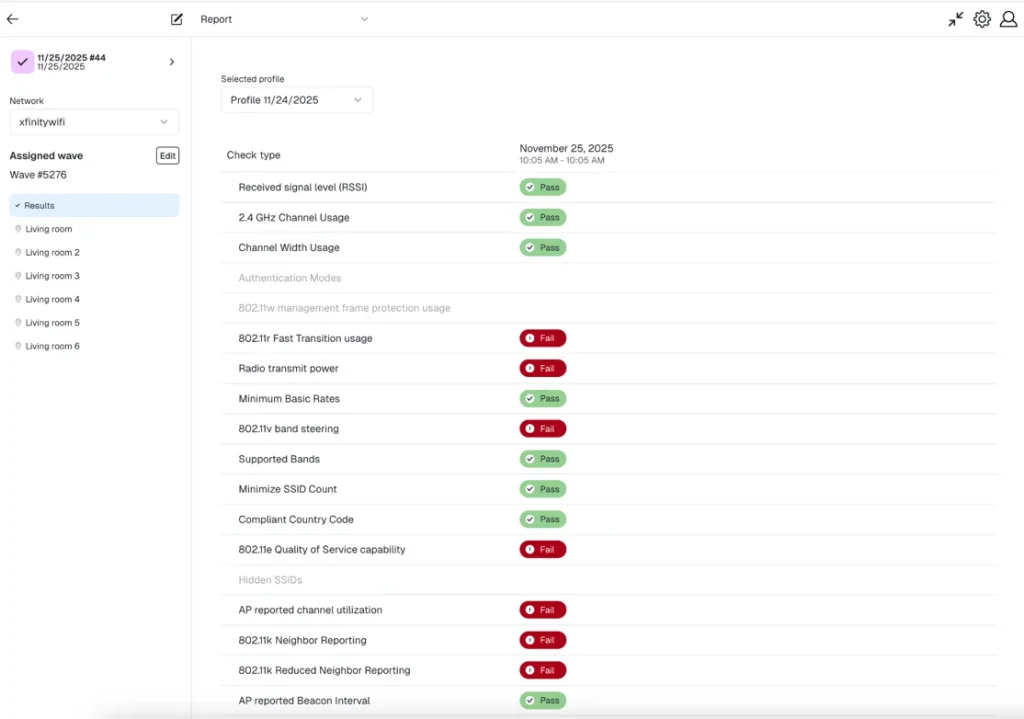

Clip adressiert dieselben Lag-Fallen wie Deep Survey

Wenn Dir das Thema Deep Survey nichts sagt, dann klick hier.

Obwohl der Prozess mit Clip etwas anders ist (zwei Geräte, manuelle Punkte), identifizierst du systematisch die gleichen Probleme:

Lag-Falle #1: Co-Channel Interference (CCI)

Das Problem: Dein Access Point und ein Nachbar-AP nutzen denselben/benachbarten überlappenden Wi-Fi-Kanal. Sie stören sich gegenseitig. Endgeräte und APs streiten sich um die Verfügbare Bandbreite in der Luft.

Wie Clip es findet:

– Interferenzmaps in Hamina Onsite zeigen sofort mehrere APs auf demselben Kanal

– SNR (Signal-to-Noise Ratio) bricht zusammen, wo sich die Coverage überlappt

– Du siehst: „Hier sind 4 APs auf Kanal 48 (5 GHz) gleichzeitig aktiv“

Lösung: Kanal-Planung optimieren (in Hamina Planner mit Clip-Daten validiert).

Lag-Falle #2: Roaming-Lücken & schlechte Übergänge

Das Problem: Gerät wechselt zwischen APs, aber verliert dabei Pakete oder – schlimmer – springt wild hin und her (Roaming-Jitter).

Wie Clip es findet:

– Du gehst mit Smartphone + Clip den Roaming-Pfad ab (z.B. Flur zwischen zwei APs)

– Kontinuierliche Messung zeigt den Handover-Punkt

– Zu schwaches Signal vor dem Wechsel? → AP-Platzierung anpassen

– Zu großer Overlap? → TX-Power reduzieren

– Clients rückwärts gewechselt? → Kanal oder Band problematisch

Beispiel aus der Praxis: „Der Konferenzsaal hatte einen Roaming-Deadspot zwischen AP_Main und AP_Backup. Mit Clip gemessen, TX-Power auf AP_Main angepasst, Deadspot weg.“

Lag-Falle #3: TX-Power Fehler

Das Problem: AP strahlt zu stark (großer Overlap, andere Kanäle interferieren) oder zu schwach (Dead Zones).

Wie Clip es findet:

– Coverage-Heatmap zeigt direkt, wo das Signal zu schwach ist

– Interferenzmaps zeigen Bereiche mit zu vielen überlagernden APs

– Du gehst zur fraglichen AP und notierst die aktuelle Power (z.B. „AP_L2_34: 20 dBm“)

– Clip-Messung vor und nach TX-Power-Änderung zeigt sofort die Auswirkung

Live-Korrektur:

1. TX-Power von 20 dBm auf 17 dBm senken

2. Mit Clip neu validieren

3. Heatmap aktualisiert sich in Real-Time

4. Besser oder schlimmer? Direkt sehen.

Lag-Falle #4: Jitter & Performance-Drops

Das Problem: Verbindung ist stabil, aber zittrig – schnelle Pakete gehen verloren, Spieler kriegen Lag.

Wie Clip es findet:

– Hamina Onsite zeigt direkt SNR und Signal-Stabiliät

– Bereiche mit schwachem/fluktuierendem Signal = Jitter-Quellen

– Kombination mit Hamina Planner Kapazitäts-Analyse/Live-View zeigt: Ist es ein Signal-Problem oder Überlast?

– Integriert mit der Orb-App (falls vorhanden) für aktive Responsiveness-Tests

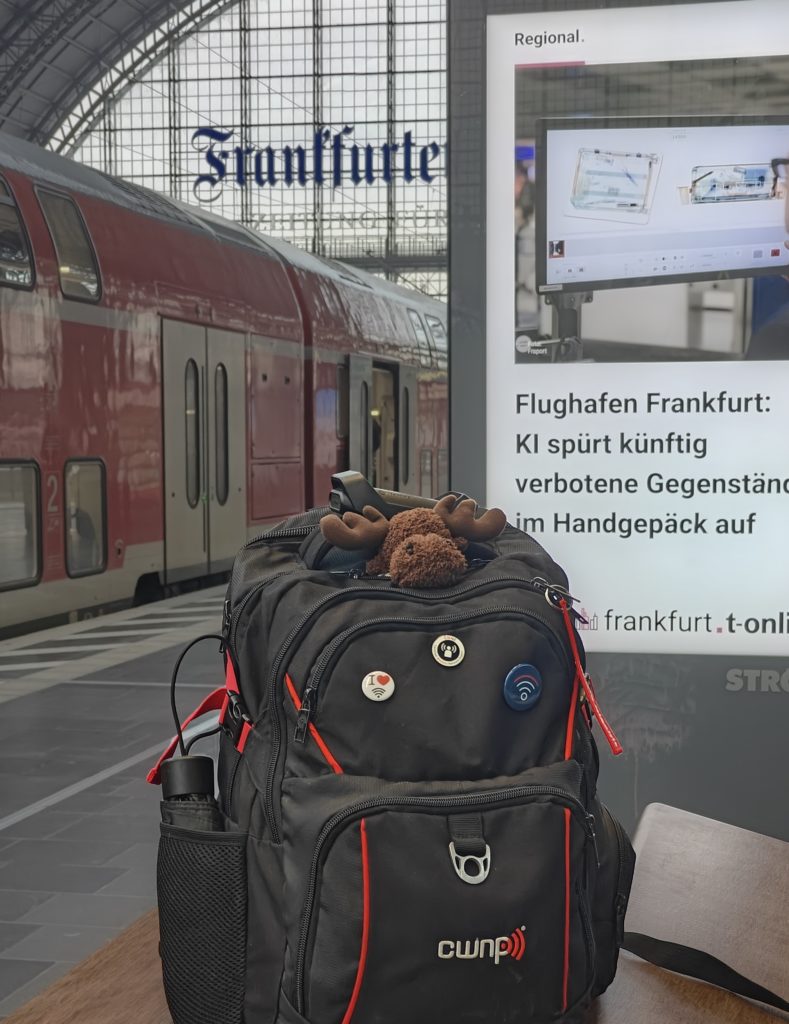

Lag-Falle #5: Kapazitäts-Engpässe

Das Problem: Signal ist gut, aber zu viele Clients auf einem AP/Kanal

->Datendurchsatz bricht ein.

Wie Clip es findet:

– Analyse in der der Onsite APP zeigt Anzahl verbundener Clients pro Kanal

– Heatmap-Overlay kombiniert mit Client-Count: „Diese Zone hat gutes Signal aber 80 Clients auf 1 AP – Überlast!“

– Lösung: Zweiten AP/Radio in diesem Bereich planen und montieren oder das Band-Steering in Hamina Planner mit der Live-View optimieren

Hamina CLIP im Vergleich zu anderen Lösungen

Deine Rolle bestimmt das Tool:

– Integrator/Freelancer mit 3+ Projekten/Monat? → Clip (ROI schnell erreicht)

– IT-Admin, der nur gelegentlich surveyt? → Deep Survey oder Wi-Fi Pro mit Clip/Nomad beauftragen (outsourcen, low-cost, Fallbezogen)

– Enterprise-Wi-Fi-Team mit echter Komplexität? → Hamina Wireless mit Clip & Nomad

(Standard in der Industrie, günstig, einfach zu bedienen und aktuell – Cloud Freigabe? ISO 27001/SOC 2)

Alternative Ekahau Connect mit Sidekick 2 – bewährt, bekannt, aufwendig, Cloud Freigabe?

– Auditor? → Nomad & Spectrum Analyzer wie den Oscium Lucid (https://oscium.com/products/wi-spy-lucid/) oder den NXT-2000 von NetAlly (https://www.netally.com/products/nxt-2000/)

Alternative 1: SIDOS – agil, neu, mietmodell

Alternative 2: Ekahau Connect mit Sidekick 2 – bewährt, bekannt, kostspielig

Clip in der Praxis: 3 Anwendungsbeispiele

Beispiel 1: AP-on-a-Stick in neuem Büro (30 Min, 1.200 m²)

Situation: Neuer Büro-Ausbau, 5 APs geplant in Hamina Planner. Aber: „Passt das wirklich?“

Ablauf:

1. Clip + iPhone mitnehmen, Gebäudeplan aus Hamina laden

2. AP an Position #1 auf Stativ montieren (ca. 3 Min)

3. Mit Clip herumgehen, ~20 Messpunkte setzen (ca. 15 Min)

4. Heatmap zeigt: AP #1 allein reicht nicht für den südlichen Flügel

5. AP an Position #2 auf Stativ, gleiche Stelle, neu messen (ca. 10 Min)

6. Jetzt perfekt – Go für Installation

Ergebnis: Statt „falsch bauen, dann ärgern“ weißt du vorher, dass die Planung funktioniert. Ersparte Fehlerkosten: 1.000 € + X

Beispiel 2: Post-Installation Validierung (2 Stunden, Retail-Store)

Situation: Neues Wi-Fi Netzwerk live, User berichten: „Hier oben (2. OG) ist Wi-Fi schwach.“

Ablauf mit Clip:

1. Zum 2. OG gehen, Clip starten

2. Continuous Survey im Lagerbereich → Heatmap zeigt: „Dead Zone unter der Metalltreppe“

3. Nächster AP wurde zu weit entfernt geplant

4. Mit Clip-Daten zurück ins Büro, in Hamina Planner: „Wenn ich AP_2 30cm näher zur Ecke stelle, ist die Zone gedeckt“

5. Techniker geht hoch, verschiebt AP 30cm, Clip-Validierung zeigt: Problem gelöst ✓

Zeit total: 2 Stunden (1h Messung, 1h Adjustierung + Validierung)

Ohne Clip: 3–4 Tage Planung, Diskussionen, mehrmals Try & Error.

Beispiel 3: Troubleshooting – „Wi-Fi bricht im Meeting ein“

(45 Min, Beratungsunternehmen)

Situation: Konferenzraum im 4. Stock hat seit 2 Wochen Wi-Fi Probleme. Viele Anrufe im Helpdesk, die Zufriedenheit sinkt, Online Meetings sind undeutlich, der Ton abgehackt.

Ablauf mit Clip:

1. User berichte: „Etwa um 14:00 wird’s schlecht“

2. Mit Clip + iPhone zum Konferenzraum

3. Survey starten, 10 Min Daten sammeln

4. Live-Heatmap zeigt: Interference im U-NII-2A Band

(Nachbar-Gebäude ist sehr nah und nutzt Kanal 58)

5. Hamina zeigt gleichzeitig: 3 APs konkurrieren hier um den Kanal 52

6. Lösung: Kanal zu einem anderen DFS-Kanal wechseln, Clip-Validierung

7. Problem weg

Ursachenanalyse: Mit Clip kannst du das in 45 Minuten klären. Ohne Clip wäre das Spekulieren, Raten, vielleicht eine Woche Leidensweg.

Clip + Hamina: Der Prozess im Detail

Workflow für typisches Wi-Fi Projekt inkl. AP-on-a-Stick

1. PLANNING PHASE (im Büro, in Hamina Planner)

– RF-Planung erstellen

– AP-Positionen simulieren

– Erwartete Coverage prognostizieren

↓

2. FIELD PREPARATION

– Clip + iPhone laden

– Gebäudeplan auf iPhone synchronisieren (offline möglich)

– AP + Stativ vorbereiten

↓

3. SITE SURVEY (vor Ort)

– AP auf Stativ montieren an geplanter Position

– Clip + Hamina Onsite starten

– 20–40 Messpunkte sammeln (Point oder Line Mode)

– Live-Heatmap mit Planung vergleichen

– Ggf. AP verschieben und neu messen

↓

4. VALIDIERUNG & DOKUMENTATION

– Screenshots, Fotos von Problemen machen

– Notizen direkt in den Gebäudeplan mit der Onsite App („Metallwand hier bricht Signal um 10 dB“)

↓

5. CLOUD SYNC & ANALYSE (zurück im Büro)

– Daten in Hamina Cloud synchronisieren

– Tiefere Analyse mit Planner Web-UI

– Report generieren

– Kunden-Handoff

↓

6. INSTALLATION & HANDOVER

– AP phys. anbringen (mit Daten aus Clip-Messung bestätigt)

– Optional und dennoch EMPFOHLEN: Post-Installation-Validierung mit Clip

Kosten & ROI: Wann lohnt sich Clip?

Investition

– Clip-Gerät: 990 € inkl. Onsite Lizenz für 6 Monate

(deutlich günstiger als Nomad, Sidos Wave, Ekahau Connect)

– Hamina Onsite Subscription: ~ 56 € / Monat

– iPhone/iPad: (wahrscheinlich schon vorhanden)

Total Entry: < 1000 €

Szenarien: Break-Even

Szenario A: Integrator mit 10 Projekten/Jahr

– Alte Methode: 2.000 € × 10 = 20.000 € /Jahr

– Mit Clip: €[Clip] + 780 € = < 1000 €

– Ersparte Zeit & Kosten: rund 19.000 € im ersten Jahr

– Break-Even: Projekt 1–2

Szenario B: IT-Admin mit 2–3 Surveys/Jahr

– Wahrscheinlich nicht ROI-positiv (Deep Survey ist billiger)

– Aber: Wenn Surveys & Troubleshooting ein häufig auftreten, rentiert sich der Clip schnell

Szenario C: Enterprise Wi-Fi-Team mit 20+ Standorten

– Clip + Hamina amortisieren sich nach dem ersten Monat

– Ständige Validierung wird praktikabel und wirtschaftlich

Häufige Fragen zu Clip

F: Wie unterscheidet sich Clip von kostenloser Wi-Fi-Analyzer-App?

A: Kostenlose Apps sind Software-basiert (nur Empfänger). Clip ist Hardware mit professioneller Messkarte und stellt sicher, dass du verlässliche, kalibrierte Messwerte hast – nicht nur Rohdaten vom iPhone-Chip.

F: Kann ich Clip auch ohne Hamina nutzen?

A: Theoretisch ja (über WiFi Explorer Pi – https://www.intuitibits.com/products/wifiexplorerpi/). Aber die Kombination ist optimiert. Ohne Hamina Onsite verlierst du die Validierungs-Features. Mit Hamina Planner wird ein komplette Lösung für den gesamten Prozess daraus.

F: Brauche ich Wi-Fi Expertentum, um Clip zu nutzen?

A: Nein. Die Hamina Onsite App ist sehr anfängerfreundlich. Aber: Verstehen, was die Heatmaps bedeuten (SNR, Interferenz, Coverage), ist wichtig. Clip is a tool, no magic. Wir bieten dazu Trainings an: Hamina Survey Specialist (https://www.hamina.com/training)

F: Wie genau sind die Messungen von Clip vs. Nomad?

A: Nomad hat 4 Radios und kann parallel scannen. Clip mit 2 Radios muss sequenziell messen, benötigt daher etwas länger. Für 95% der Use Cases ist Clip ausreichend. Da der Clip sehr neue intelligente scanning Methoden verwendet ist in vielen Fällen der Unterschied kaum nachweisbar. Bereits live in verschiedenen Szenarien mehrfach getestet und bewiesen.

F: Kann ich Clip auch außen/im Freien nutzen?

A: Ja. Hamina Onsite unterstützt auch Outdoor-Surveys. Clip funktioniert überall, solange das iPhone eine Verbindung hat.

F: Was ist die Akkulaufzeit von Clip?

A: [typisch 3–6 Stunden Continuous Operation, vs. 4h beim Nomad]

F: Muss ich das Gebäude als 3D-Modell in Hamina haben?

A: Nein. 2D-Grundriss reicht völlig aus. 3D ist ein optionales Feature für komplexe Umgebungen.

Das größere Bild: Clip als Werkzeug der Wi-Fi-Profis 2026

Wi-Fi Surveys sind nicht mehr „großes Event, einmal im Jahr, teuer“. Sie sind ein kontinuierliches Optimierungs-Tool.

Mit Clip wird das möglich:

– Schnelle Validierung vor Installations-Commit

– Agile Justierung im laufenden Betrieb

– Präventives Troubleshooting statt reaktives „Problem-Löschen“

– Kostenfreundliche Skalierung – mehr Standorte, ähnliche Kosten

Clip richtet sich an Techniker, die wissen: Gute Wi-Fi-Planung ist nicht einmalig – es ist ein Prozess.

Zusammenfassung: Clip – das professionelle Messgerät für deine Tasche

Clip ist nicht für jeden – aber für fast alle.

Wenn deine Antwort auf folgende Fragen ja ist:

– ✓ Machst du 3+ Wi-Fi-Surveys pro Quartal?

– ✓ Brauchst du schnelle, vor-Ort-Validierung statt Remote-Reports?

– ✓ Arbeitet dein Team bereits mit Hamina Planner?

– ✓ Kosteneffizienz ist wichtig (Small-to-Medium Business)?

– ✓ Du möchtest Live-Troubleshooting, nicht nur Planung?

Dann ist Clip die richtige Wahl.

Das Gerät ist:

– Klein & leicht: Passt in die Jackentasche

– Intelligent: Misst fast alle Lag-Fallen automatisch

– Wirtschaftlich: 5–10× billiger als traditionelle Enterprise-Geräte

– Praktisch: Zwei Geräte, kabellos, einfacher Workflow, zuverlässige Ergebnisse

– Hamina-native: Integriert mit Planner & Onsite Cloud

Mit Clip + Hamina hast du ein komplettes Wi-Fi-Assessment- und Optimierungs-Portfolio – skalierbar von Remote-Überblicks-Assessment bis zum detaillierten Feld-Troubleshooting.

→ Zeit die Wi-Fi-Surveys zu modernisieren.

Next Steps

1. Kostenlose Demo buchen: Clip + Hamina Onsite testen

2. Technisches Datenblatt: hamina.com/clip Clip Specs & Kompatibilität

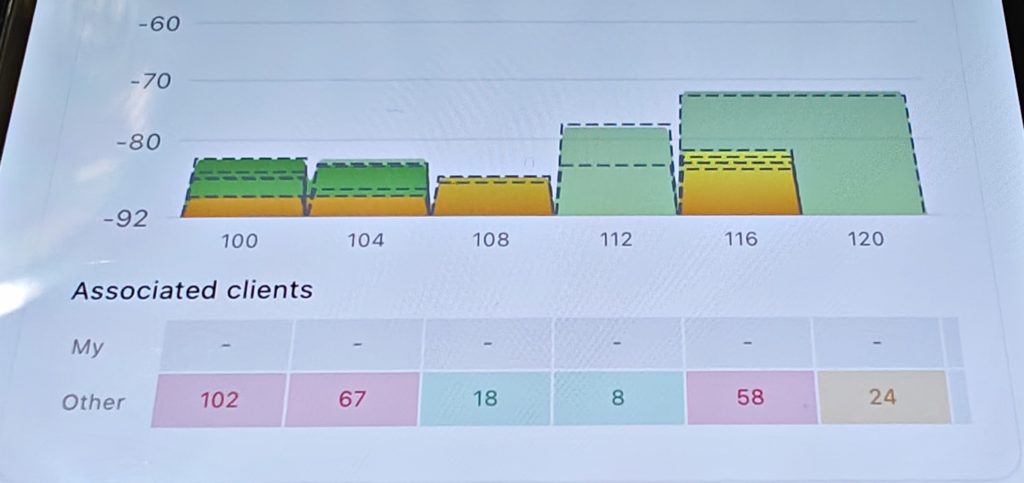

Bonus TIP für Hamina Wireless Nutzer:

Die Network Status Heatmap – Alles auf einen Blick

Mit der neuesten Version (20.01.2026) von Hamina Network Planner gibt es jetzt die Network Status Heatmap für alle!

Diese fungiert als „Zusammenfassung“ (Roll-up) aller anderen Heatmaps – du siehst auf einen Blick, ob dein Netzwerk alle Anforderungen erfüllt oder nicht. Die Farbkodierung zeigt dir sofort, wie viele Heatmaps deine Vorgaben nicht erfüllen.

Was bedeutet „Anforderung erfüllen“?

In Hamina Network Planner definierst du für jede Heatmap einen Schwellenwert (höchster akzeptabler Wert).

Beispiel Coverage: Wenn du „-65 dBm“ eingestellt hast, gilt Coverage als erfüllt, wenn sie -65 dBm oder besser ist (also z. B. -60 dBm = grün, -70 dBm = rot).

Typische Standard-Schwellenwerte (anpassbar):

- Primäre Coverage: Grün ≥ -65 dBm, Gelb -70 dBm, Rot < -75 dBm

im Beispiel oben -67 dBm - Sekundäre Coverage: Grün ≥ -67 dBm, Gelb -70 dBm, Rot < -75 dBm

im Beispiel oben -68 dBm - SNR: Grün ≥ 25 dB, Gelb 20 dB, Rot < 15 dB

im Beispiel oben erfüllt und daher ausgeblendet - Interferenz: Grün <2 APs, Gelb 3 APs, Rot 4 APs

im Beispiel oben 4 APs - Kanal Auslastung: Grün 0-30%, Gelb 30-49%, Rot >49%

im Beispiel oben 50 %

Network Status ein-/ausschalten

Möchtest du bestimmte Heatmaps (z. B. nur Coverage + SNR) in der Zusammenfassung einbeziehen?

- Legend-Menü (Popover) ausklappen

- „Global Settings“ auswählen

- Toggle-Switches unten für jede Heatmap aktivieren/deaktivieren

Mouseover-Inspector: Welche Anforderung scheitert genau?

Genau wie bei allen anderen Heatmaps hat Network Status einen Mouseover-Inspector: Fahre mit der Maus über eine Stelle, und du siehst exakt, welche Anforderungen scheitern:

- „Coverage: -72 dBm (unter -65 dBm) ❌“

- „SNR: 18 dB (unter 25 dB) ❌“

- „Interferenz: 3 APs auf Kanal 48 ❌“

Perfekt für eine schnelle Analyse: Wenn Network Status rot ist, siehst du sofort, was die Ursache ist – und kannst gezielt optimieren.

#HaminaCLIP #HaminaWireless